-

Pre-trained Big Transformers (3) | ALBERT, RoBERTa 등 | 패스트캠퍼스 챌린지 44일차딥러닝 2022. 3. 8. 19:51

BERT를 비롯한 language model들은 모델의 크기를 키워서 성능을 높이고자 하였다. 하지만 모델의 크기가 크면 그에 따르는 메모리의 제약이나, 학습에 필요한 시간 제약이 있다. 또한, hidden layer가 너무 커지면 오히려 성능이 감소하는 문제 또한 있었다. ALBERT는 BERT를 가볍게 개량한 버전이다. ALBERT에서는 입려 토큰 임베딩 사이즈가 은닉층 사이즈 보다 적을 떄 은닉층이 커질 떄 성능이 감소하는 문제가 해결됨을 발견하고 이에 따라 facotrized embedding parameterization으로 입력 파라미터 사이즈를 줄였고, corss layer parameter sharing, 즉 RNN이나 CNN과 같은 parameter sharing 기법으로 전체 파라미터 수를 줄였다. 이렇게 모델 사이즈를 줄였음에도 불구하고 BERT와 비견할만한, 혹은 더 나은 성능을 보였다.

RoBERTa는 Robustly Optimized BERT Pretraining Approach의 약자로, BERT의 사전훈련을 더욱 강건히 하는 것에 목표를 두었다. 우선 사전훈련 대상 데이터를 늘린다. 그리고 dynamic masking이라는 기법을 통해 더 다양한 masking에 모델이 노출되도록 한다. 이 외에도 next sentence prediction 과업도 여러 방법의 실험을 통해 최적화 시킨 모델이다.

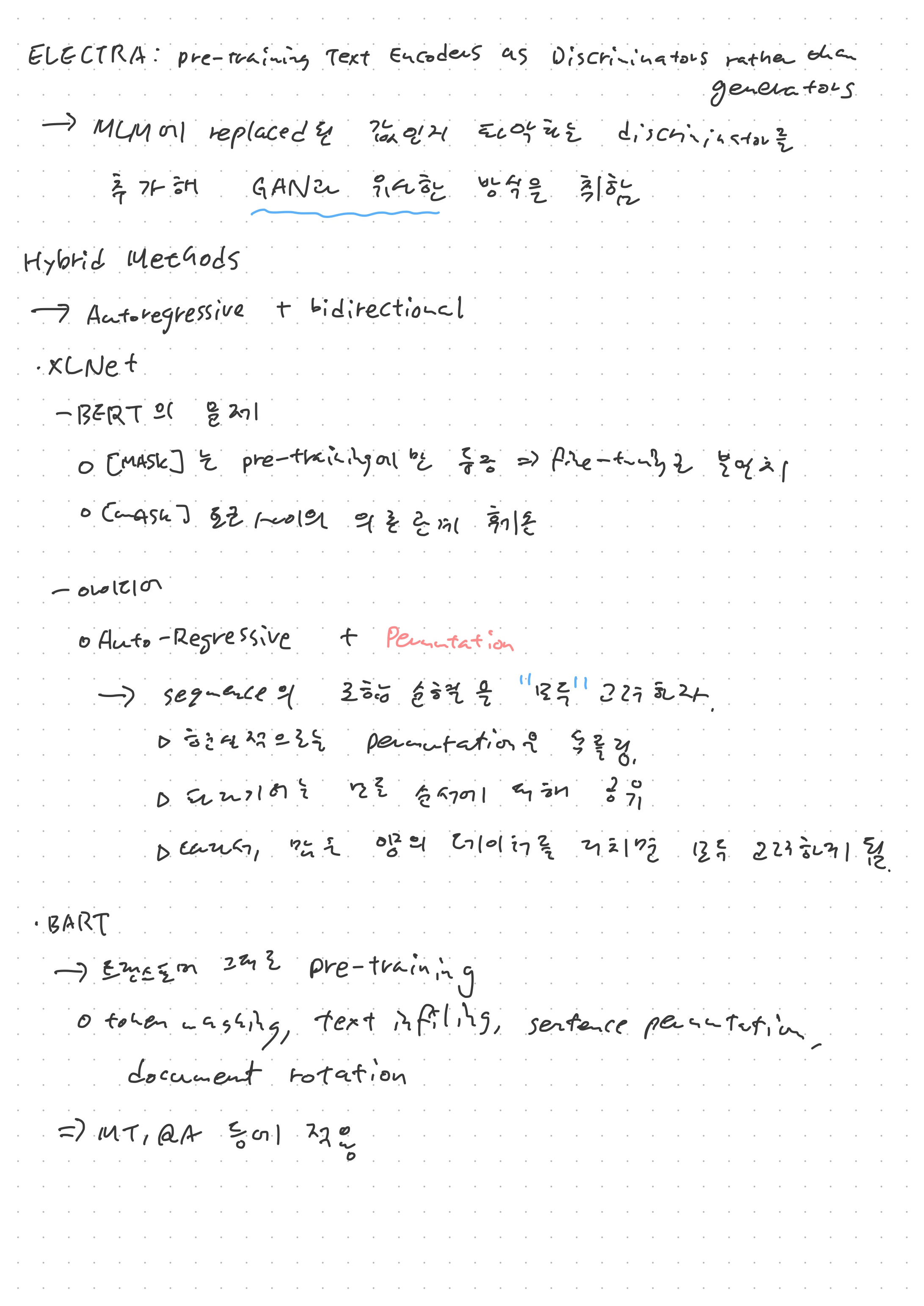

Encoder를 사용한 모델의 마지막으로 ELECTRA는 Maked Language Modeling에서 replaced된 값인지 아닌지를 파악하는 discriminator를 추가한 방식인데, 이는 Generative Adversarial Network와도 같은 아이디어라 볼 수 있다. 이러한 모델들은 모두 BERT보다 특정 도메인에서의 성능을 향상시켰는데, 그래도 전반적인 도메인에서 BERT의 성능이 워낙 좋기 때문에 BERT를 사용한다고 해서 뭐라고 하지는 않는 분위기 같다. 특히, BERTology 연구들이 여전히 BERT를 기반으로 하되, 다른 트랜스포머 기반 모델들도 살펴보는 식으로 이루어지고 있다.

인코더를 사용한 언어 이해 모델, 디코더를 사용한 언어 생성 모델이 있다면, 이 두 개를 모두 사용하는 경우를 생각해 볼 수 있을 것이다. 이러한 경우의 대표적인 모델이 XLNet과 BART이다. XLNet은 BERT의 MLM 문제를 지적하며 permutation을 활용하여 bidirectional autoregressive model을 만들어 낸 것이다. 즉, 입력 토큰을 단순히 마스킹 시키는 데에서 더 나아가, 입력 토큰으로 만들 수 있는 여러 조합들을 생각하고자 한 모델이다.

마지막으로 BART는 트랜스포머를 그대로 pre-training 시킨 모델로, token masking이외에도 text infilling, sentence permutation, document rotation 등 여러 방법으로 pre-training을 진행하였다. 이러한 BART 모델의 경우 언어 이해와 생성 둘 다 어느정도 잘 하기 때문에, QA나 Machine Translation과 같이 이해와 생성을 동시에 진행해야 하는 과업에서 쉽게 활용될 수 있다.

본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성되었습니다. https://bit.ly/37BpXiC

'딥러닝' 카테고리의 다른 글

Flow-Based Generative Model (2) | 패스트캠퍼스 챌린지 46일차 (0) 2022.03.10 Flow-Based Generative Model (1) | 패스트캠퍼스 챌린지 45일차 (0) 2022.03.09 Pre-trained Big Transformers (2) | GPT-3, BERT | 패스트캠퍼스 챌린지 43일차 (0) 2022.03.07 Pre-trained Big Transformers (1) | 패스트캠퍼스 챌린지 42일차 (0) 2022.03.06 Transformer (2) | 패스트캠퍼스챌린지 41일차 (0) 2022.03.05