-

인공 뉴런과 Dense Layer | 패스트캠퍼스 챌린지 01일차딥러닝 2022. 1. 24. 21:54

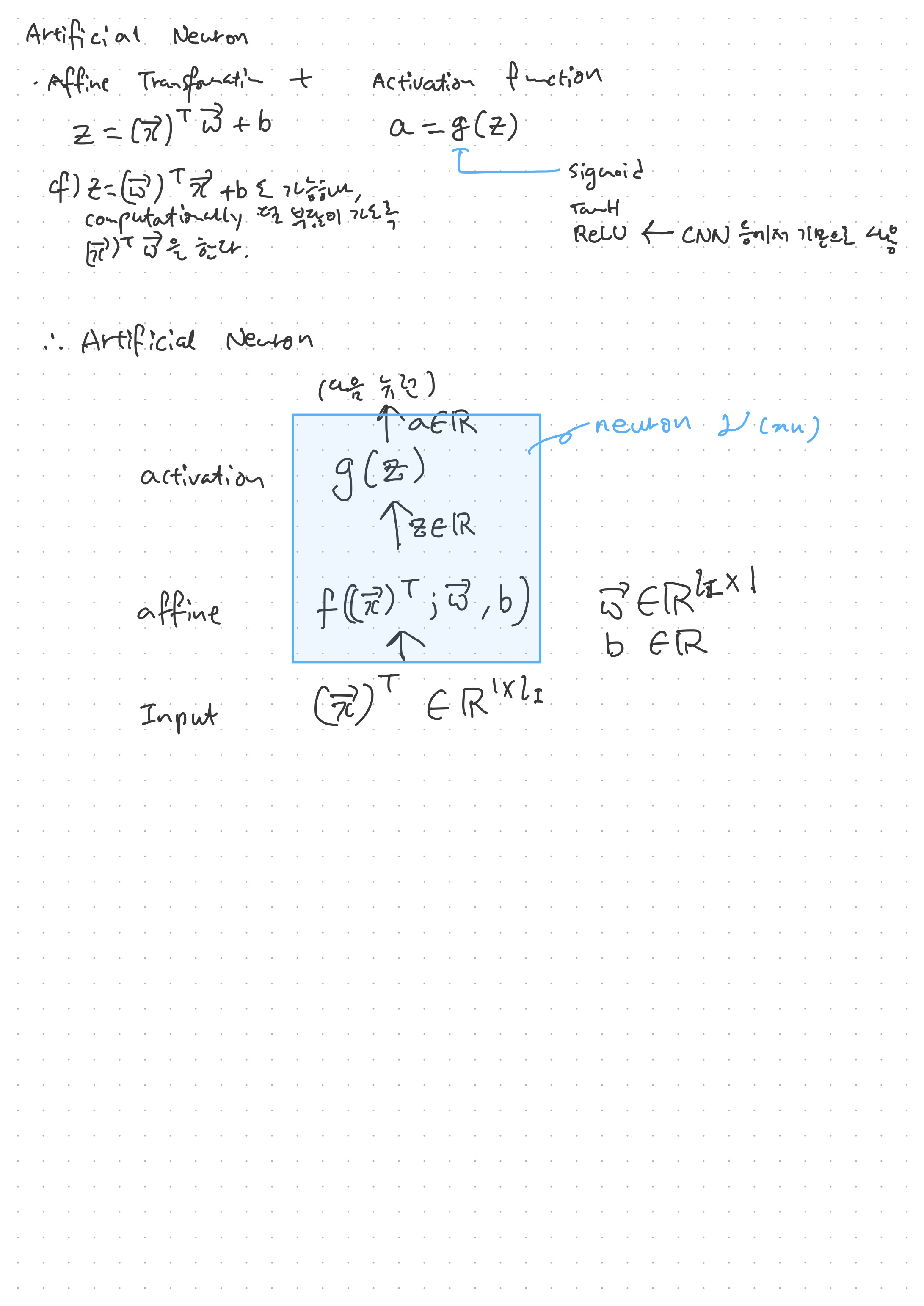

인공 뉴런은 affine transformation과 activation function이 합쳐진 것을 뜻한다. Affine transformation은 parameteric function의 일환인데, 함수(function)가 입력값 x에 대해 다른 값을 반환한다고 하면, parameteric function f(x; p)는 parameter에 따라 다른 출력값을 보인다. 즉, 익히 봐 왔던 1차함수 y = ax+b 같은 경우, a, b라는 두 개의 parameter에 따라 y값이 달라지므로 parameteric function이다.

딥러닝은 기계가 예상한 함수의 결과가 실제 결과과 유사하도록 최적의 parameter 값을 찾는 과정이다.

이러한 인공 뉴런이 모이면 레이어라고 부른다. 즉, 하나의 레이어는 인공 뉴런의 벡터라고 볼 수 있을 것이다. 하나의 레이어에서 각각의 인공 뉴런은 하나의 필터 역할을 한다고 볼 수 있다. 즉, 하나의 뉴런은 입력값에 대해 특정 부분을 집중해서 살펴보는데, 9x9 픽셀을 가진 그림을 입력값으로 준다고 한다면, 하나의 뉴런은 상단 가로만, 다른 뉴런은 우측 세로만 보는 식으로 학습된다는 개념과 같을 듯 싶다.

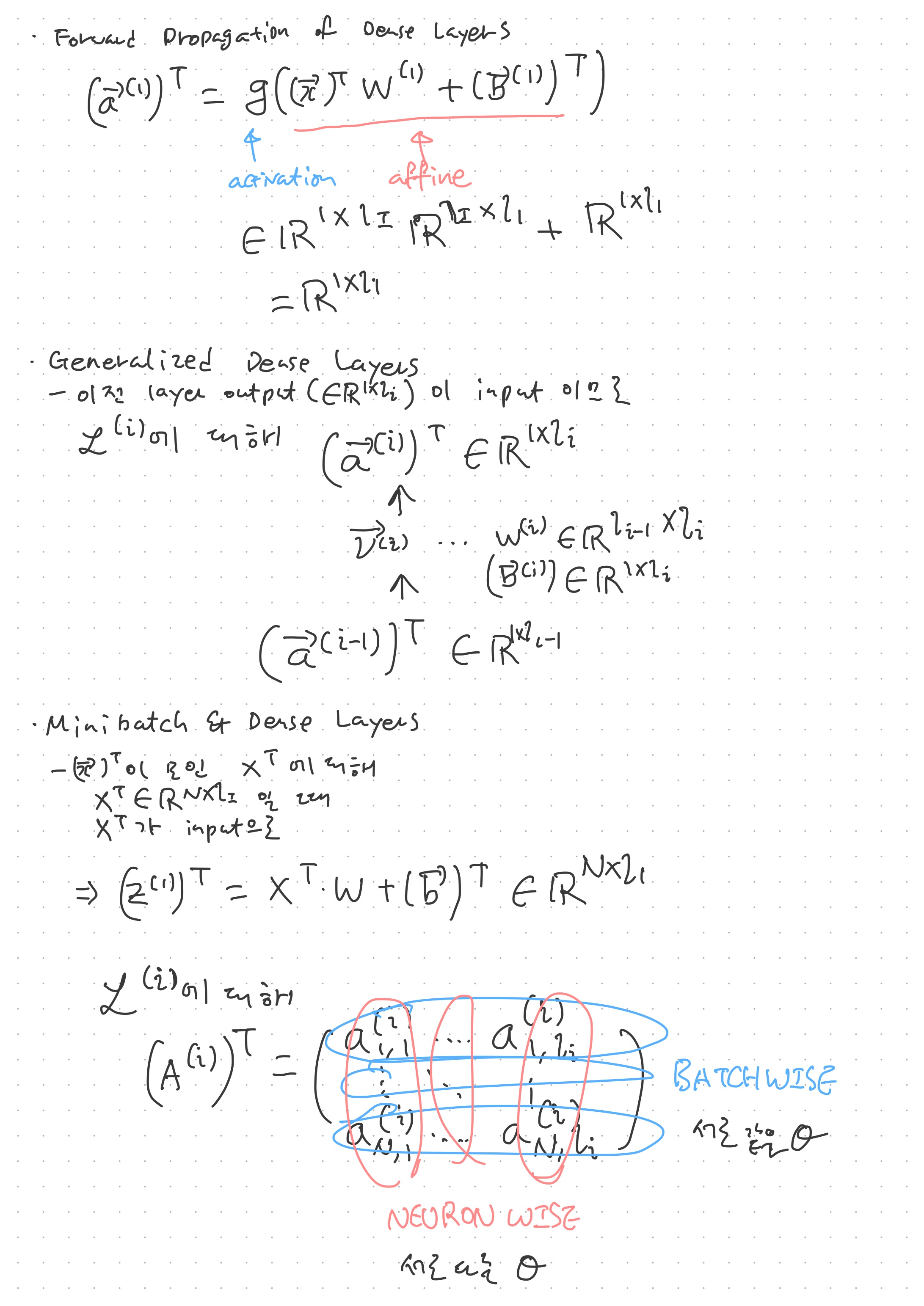

Dense Layer는 이러한 인공 뉴런과 입력값 사이의 모든 가능한 연결이 이루어진 네트워크다. 이 때 네트워크는 순수히 전산적 용어로, 엣지와 노드의 집합을 뜻하지, 컴퓨터 네트워크와는 크게 상관이 없다. 참고로 Fully-Connected Layer는 Dense Layer를 뜻하는데, tensorflow에서는 dense로 사용하는 듯 하다.

자세한 내용은 수업 내용을 필기한 아래 그림을 참조. 수식을 직접 써 가며 설명하면 좋은데, 아직 이 플랫폼에서 수식을 입력하는 방법을 잘 모르겠다.

챌린지 첫번째 날이다. 강의에서 파이썬 기초 부분은 건너뛰고, 기초 수학 부분부터 시작하기로 했다. 사실 기초 수학이기에 log 연산 부터 가르치면 어쩌나 나름 걱정했는데, 그 정도 되는 수업은 부록으로 딸려 있으니 걱정하지 않아도 될 듯 하다. 대학원을 거치면서 딥러닝에 대해 막연하게 알고 있었는데, 이 내용을 기반이 되는 수학적인 연산과 함께 공부하니 공부한 내용을 확인할 수도 있고, 맨날 헷갈렸던 레이어 수 계산도 제대로 할 수 있게 된 것 같아 만족스럽다.

본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성되었습니다. https://bit.ly/37BpXiC

'딥러닝' 카테고리의 다른 글

Convolution Layers with Multiple Channel | Pooling, Striding, Padding | 패스트캠퍼스 챌린지 05일차 (0) 2022.01.28 Convolution Layers | 패스트캠퍼스 챌린지 04일차 (0) 2022.01.27 Loss functions: MSE, BCE, CCE | BLAS 문제를 만나다 | 패스트캠퍼스 챌린지 03일차 (0) 2022.01.26 Activation Functions: Sigmoid & Softmax | 패스트캠퍼스 챌린지 02일차 (0) 2022.01.25 딥러닝 강의를 수강하기 앞서 : 컴퓨터 환경 구축하기 (0) 2022.01.23